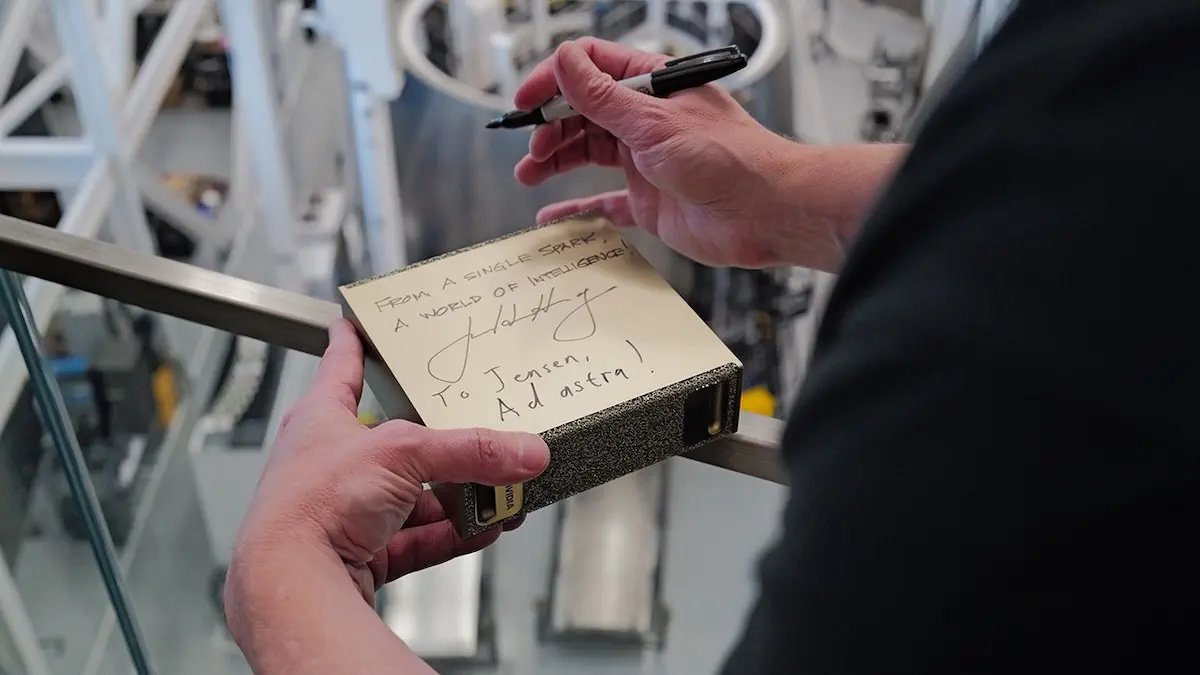

Jensen Huang, le PDG de Nvidia s’est rendu en personne au Texas pour remettre le nouveau DGX Spark à Elon Musk. La scène s’est déroulée le 13 octobre dernier, sur le site de Starbase, quelques heures avant le décollage du onzième vol d’essai de Starship. Le patron de Nvidia tenait dans ses mains le plus petit superordinateur d’intelligence artificielle au monde : un appareil de 1,2 kilogramme concentrant une puissance de calcul jusqu’ici réservée aux centres de données.

Cette livraison symbolique n’est pas anodine. Elle rappelle en effet un événement similaire survenu neuf ans plus tôt.

Un retour aux sources

En 2016, Huang avait déjà effectué une livraison mémorable. Le destinataire était le même, mais le contexte différait. Musk venait alors de cofonder OpenAI, une petite structure encore méconnue du grand public. Huang lui avait alors apporté le premier système DGX-1, un superordinateur conçu pour permettre aux chercheurs de réaliser leurs ambitions.

« En 2016, nous avons conçu le DGX-1 pour offrir aux chercheurs en IA leur propre superordinateur. J’ai livré le premier système à Elon dans une petite start-up appelée OpenAI, et c’est ainsi que ChatGPT est né, lançant la révolution de l’IA », a déclaré Jensen Huang dans le communiqué officiel de Nvidia.

Ce premier système a permis d’entraîner les modèles à l’origine de ChatGPT. Neuf ans plus tard, le DGX Spark offre une puissance de calcul comparable dans un format de bureau. Musk a souligné sur les réseaux sociaux que le nouvel appareil délivre environ 100 fois plus de puissance de calcul par watt que le DGX-1 original.

Une puissance concentrée

Le DGX Spark est basé sur le superchip GB10 Grace Blackwell conçu par Nvidia. Ce composant associe un processeur ARM à 20 cœurs et un GPU Blackwell équipé de cœurs Tensor de cinquième génération. Le système dispose de 128 Go de mémoire unifiée LPDDR5x partagée entre le processeur et le GPU, avec une bande passante supérieure à 270 Go par seconde.

Les performances annoncées atteignent jusqu’à 1 pétaflop, soit un million de milliards d’opérations par seconde. Cette configuration permet de faire tourner des modèles d’intelligence artificielle (IA) comportant jusqu’à 200 milliards de paramètres. Pour les besoins plus exigeants, deux unités Spark peuvent être connectées via la technologie ConnectX-7, ce qui double la mémoire disponible et permet de gérer des modèles de plus de 400 milliards de paramètres.

Suivez toute l’actualité d’Essential Homme sur Google Actualités, sur notre chaîne WhatsApp, ou recevoir directement dans votre boîte mail avec Feeder.

Une démocratisation programmée

Nvidia vise clairement à rendre accessible une infrastructure jusqu’ici réservée aux géants de la technologie. Les premiers bénéficiaires du DGX Spark sont Google, Meta et Microsoft, ainsi que des institutions de recherche comme le NYU Global Frontier Lab. Le dispositif est proposé au prix de 3 999 dollars sur le site de Nvidia et chez des partenaires comme Dell, HP, Lenovo, Acer, Asus, Gigabyte et MSI.

Le constructeur positionne le Spark comme un outil destiné aux développeurs, aux data scientists et aux roboticiens qui ont besoin d’entraîner ou d’affiner des modèles localement. L’appareil embarque la pile logicielle complète de Nvidia, incluant les bibliothèques CUDA et les frameworks nécessaires au développement d’applications d’intelligence artificielle (IA).

Le système fonctionne sous DGX OS, une distribution Linux propriétaire optimisée pour les charges de travail d’intelligence artificielle. Il ne s’agit donc pas d’une machine polyvalente, mais d’une plateforme spécialisée conçue pour prototyper des modèles avant un déploiement à plus grande échelle.

Des interrogations sur la production

Malgré l’annonce officielle de la disponibilité du produit, certains observateurs du secteur restent prudents. Selon des informations relayées par le site SemiAccurate, les volumes de production initiaux seraient extrêmement limités. Le nombre d’unités distribuées à l’ensemble des fabricants partenaires serait même inférieur à dix, ce qui conduit certains analystes à qualifier cette opération d’action de communication plutôt que de lancement commercial à grande échelle.

Cette situation n’est pas inhabituelle pour Nvidia lors du lancement de nouvelles gammes de produits. Les premières séries servent souvent de test grandeur nature avant une montée en charge progressive de la production.

Un marché en pleine expansion

Le lancement du DGX Spark intervient alors que la demande en infrastructures d’intelligence artificielle ne cesse de croître. Les entreprises cherchent en effet à réduire leur dépendance aux services cloud pour des raisons de coûts, de latence et de confidentialité des données. Disposer d’une capacité de calcul locale devient un atout stratégique pour de nombreuses organisations.

Nvidia mise sur ce segment intermédiaire entre le matériel grand public et les installations de centres de données. Le Spark s’adresse aux équipes qui ont dépassé les capacités des GPU classiques, mais qui n’ont pas besoin d’investir dans des racks entiers de serveurs.

Avec 128 Go de mémoire unifiée, il est possible de traiter des modèles volumineux. Les cartes graphiques traditionnelles atteignent souvent leurs limites à ce niveau, ce qui oblige à fragmenter les calculs ou à recourir à des solutions cloud.

Une stratégie cohérente

Avec le DGX Spark, Nvidia complète sa gamme de solutions d’intelligence artificielle. Le constructeur propose également le DGX Station, une version plus puissante équipée du superprocesseur GB300 Grace Blackwell Ultra. Ces systèmes s’inscrivent dans une offre globale qui va des composants pour développeurs aux supercalculateurs pour data centers.

La livraison à Musk sur le site de Starbase renforce la dimension symbolique du produit. SpaceX développe en effet des systèmes d’IA pour ses projets, notamment pour le pilotage autonome et l’analyse de données spatiales. Le DGX Spark trouve naturellement sa place dans cet écosystème technologique.

La commercialisation a débuté cette semaine. Les premières livraisons permettront de vérifier si le produit tient ses promesses et si Nvidia parvient à augmenter rapidement sa production pour répondre à la demande potentielle.